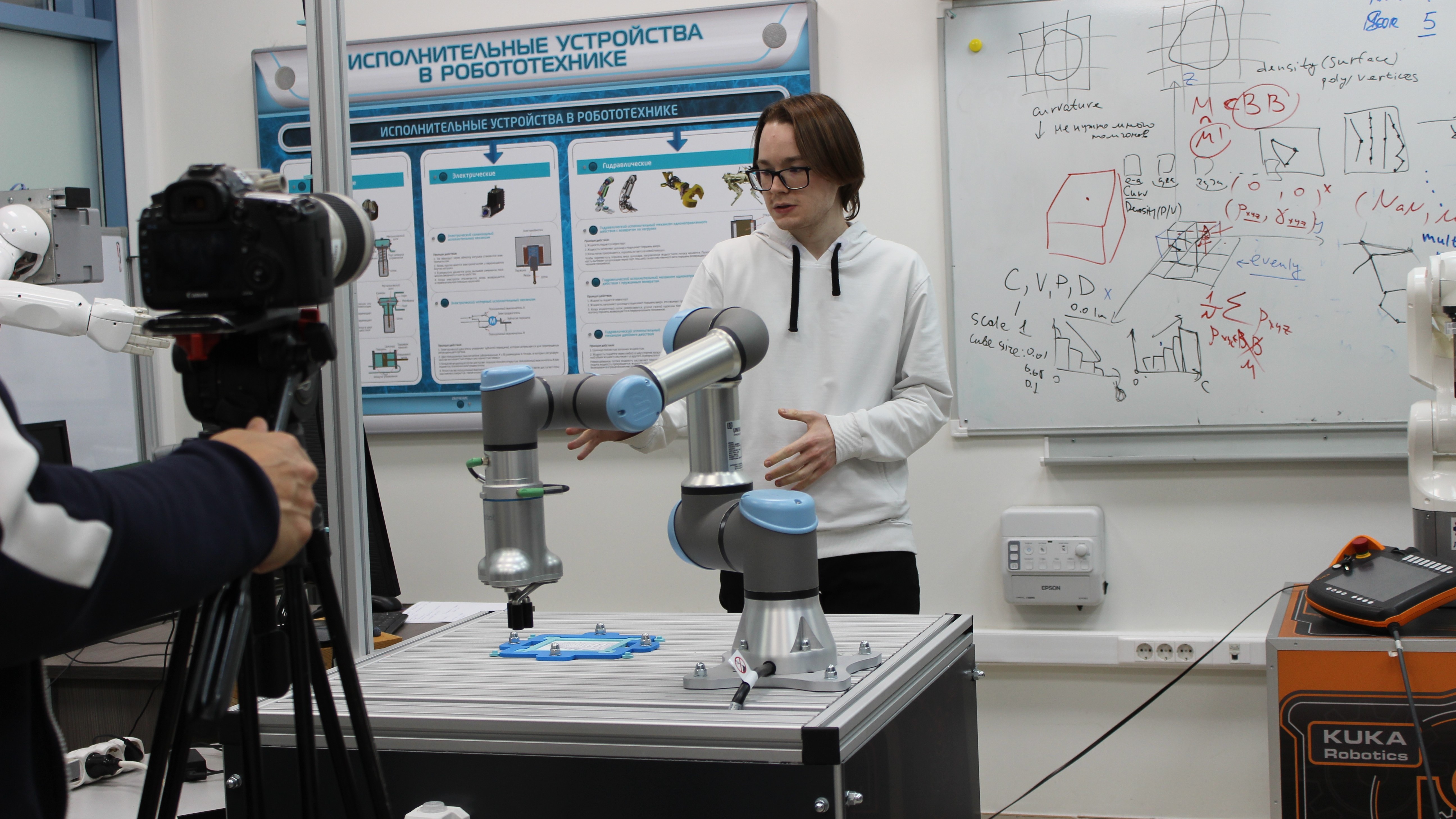

Чтобы робот понимал команды, можно использовать пульт управления, а можно жесты. Но не все движения человека понятны машинам, поэтому в Лаборатории интеллектуальных робототехнических систем Института информационных технологий и интеллектуальных систем Казанского федерального университета придумали пользовательский интерфейс на основе компьютерного зрения для определения положения рук.

«Программа интерфейса дополненной реальности для управления роботом Universal Robots UR5e при коллаборативной сборке учебного мобильного робота» и «Программа для интерпретации жестов человека-оператора для управления роботом UR5e с помощью компьютерного зрения» недавно получили свидетельство о государственной регистрации программ для ЭВМ. Сотрудники лаборатории интеллектуальных робототехнических систем ИТИС объяснили необходимость таких решений.

«Это облегчает процесс работы с роботом и делает взаимодействие с ним немного интереснее. Человеку нет надобности использовать родной для робота пульт обучения для управления. Он достаточно увесистый, обладает марким глянцевым экраном», – отметил один из авторов идеи, лаборант-исследователь ЛИРС Максим Мустафин.

Теперь благодаря новому интерфейсу можно определять положение пальцев рук пользователя и распознавать различные команды человека, направленные на управление роботом. Для этого нужна лишь веб-камера и компьютер с хорошей производительностью. Но чтобы избежать некорректного понимания роботом команд, и как следствие, выполнения тех, которые не подразумевались пользователем, провели ряд тестов.

«По результатам эксперимента выяснилось, что некоторым участникам неудобно показывать одни жесты, а иным другие. Поэтому было принято решение по разработке интерфейса, для взаимодействия с которым необходим один жест, являющийся физиологически удобным для людей», – рассказал Максим.

Как это выглядит? Человек-оператор смыкает кончики указательного и большого пальцев для нажатия на виртуальные кнопки. Таким образом, он использует один жест для взаимодействия с элементами интерфейса на основе компьютерного зрения с целью управления роботом.

На данный момент проект находится на этапе активной разработки прототипов и апробации идей по улучшению интерфейса. По словам ученых ЛИРС, с каждым новым экспериментом они видят все больше путей развития этой идеи.

111

111